Le paradoxe du cloud : tout fonctionne jusqu’au jour où tout s’arrête

On vend souvent le cloud comme une promesse simple : plus de disponibilité, plus de sécurité, plus de résilience. Et dans la plupart des cas, ça marche. Jusqu’à ce qu’un incident “invisible” coupe l’accès : un DNS qui se dérègle, une config déployée au mauvais endroit, une automatisation IAM qui casse la prod. L’infrastructure tourne toujours mais ton service, lui, est indisponible. C’est là que commence le vrai sujet : la résilience cloud n’est pas automatique. C’est un système (technique + humain + organisationnel) à concevoir et à tester.

Cloud : définition, exemples concrets, et ce que ça change vraiment

Par définition, le cloud désigne des serveurs accessibles via Internet, ainsi que les applications et les données qui y sont hébergées. Au lieu d’exécuter des programmes et de stocker des informations sur des machines locales, particuliers et entreprises utilisent des serveurs distants opérés dans des centres de données, répartis dans le monde. Cela évite d’acheter, d’installer et de maintenir soi-même du matériel et des logiciels.

Exemples concrets :

- Google Photos / Drive : tes fichiers sont stockés “ailleurs”, accessibles partout (tant que l’identité + le réseau + le service fonctionnent).

- Microsoft 365 : la suite bureautique dépend d’une chaîne de services cloud.

- Applications métiers : hébergées sur AWS/Azure/GCP, avec des briques (DNS, IAM, API, CI/CD) qui deviennent aussi critiques que le code.

Dans le cloud, vous ne dépendez pas seulement d’un “serveur”, mais d’un ensemble (réseau, identité, routage global, automatisations).

Le paradoxe du cloud : disponible sur le papier, fragile dans la réalité

Le cloud est souvent présenté comme intrinsèquement résilient : redondance, haute disponibilité, élasticité. Pourtant, des pannes majeures continuent de se produire à grande échelle, avec des impacts réels sur les opérations.

Ce paradoxe s’explique fréquemment par une confusion entre :

- Disponibilité : “le service est accessible maintenant” (souvent mesuré en %).

- Résilience : “le service encaisse l’incident, se dégrade proprement, et se rétablit vite” (incluant l’organisation, les runbooks, la restauration, la détection).

Même quand un fournisseur respecte ses engagements, les SLA (Service Level Agreement) ne couvrent pas toujours toutes les dépendances nécessaires à la continuité d’un service (DNS, identité, intégrations SaaS, routage global, etc.).

Résilience et sécurité cloud : le lien que beaucoup sous-estiment

La résilience cloud ne se limite pas à “éviter les pannes matérielles”. Elle inclut la capacité à survivre à des incidents logiques et opérationnels :

- Erreur de configuration,

- Compromission d’identité,

- Automatisation défaillante,

- Restauration impossible ou non testée,

- Dépendances tierces non cartographiées.

Dans le modèle de responsabilité partagée, le fournisseur sécurise la plateforme, mais le client reste responsable d’une grande partie : configuration, IAM, données, continuité d’activité, supervision.

Ce que les SLA (Service Level Agreement) couvrent souvent et ce qu’ils ne couvrent pas :

| Souvent couvert | Disponibilité d’un composant ou d’une plateforme (sous conditions). |

| Souvent hors périmètre | Erreurs de config côté client, identités, clés/API, dépendances SaaS, restauration mal préparée, chaîne DNS/IdP, ou effets de cascade multi-services. |

Évaluez gratuitement votre niveau de sécurité cloud en quelques minutes.

Les 4 vecteurs de rupture qui font tomber des services cloud “solides”

Erreurs de configuration dans les couches de contrôle (control plane)

Beaucoup d’incidents majeurs naissent dans les couches de contrôle : routage global, configuration edge, DNS, services d’entrée.

Exemple : Azure Front Door (2025) une modification de configuration a déclenché une perturbation large, avec des effets sur le routage/DNS et des indisponibilités en chaîne.

Une infra peut rester “up”, mais si l’entrée globale ou la couche de contrôle dysfonctionne, le service devient inaccessible.

Identités et automatisations : quand l’opérationnel casse la prod

Les identités cloud (comptes à privilèges, clés API, pipelines CI/CD) sont une surface de fragilité majeure : une erreur humaine ou une automatisation mal paramétrée peut provoquer une indisponibilité.

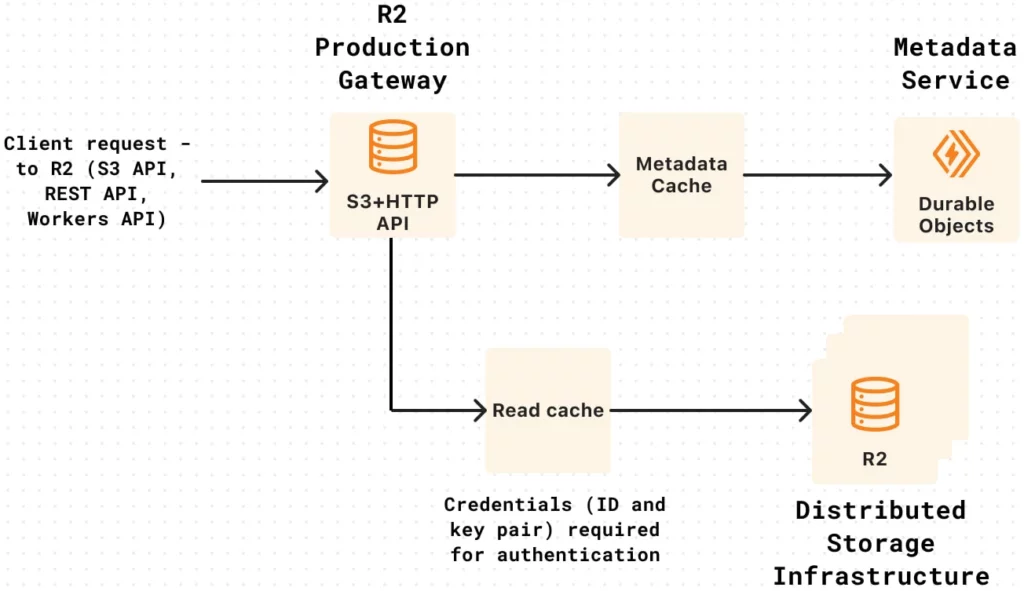

Exemple : Cloudflare (2025) incident affectant plusieurs services dont R2 (un service de stockage d’objets pour stocker et servir des fichiers/données), avec une période où 100% des écritures ont échoué et une partie des lectures a été impactée. Cloudflare publie un post-mortem détaillé.

R2 Gateway Worker authentication diagram – Source: Cloudflare : https://blog.cloudflare.com/cloudflare-incident-march-21-2025/

La résilience dépend aussi des pratiques IAM/OPS : séparation des environnements, mécanismes de rollback, protections sur les actions sensibles, rotation de secrets contrôlée.

Sauvegardes : présentes mais inutilisables (ou trop lentes)

Avoir des sauvegardes ne suffit pas. La résilience exige :

- Des objectifs clairs (RPO/RTO),

- Des restaurations testées,

- Une isolation suffisante (ex. immutabilité, séparation des comptes, protection contre erreurs/compromissions, externalisation des sauvegardes).

Les crises révèlent souvent que “restaurer” n’a jamais été testé en conditions réalistes.

Dépendances externes invisibles : le domino effect

Une architecture cloud dépend de briques parfois sous-cartographiées : DNS, IdP/SSO, API tierces, SaaS, opérateurs. Une seule défaillance peut provoquer un effet de cascade.

Exemple : AWS / DynamoDB (2025) un post-mortem explique une condition de course dans un système d’automatisation DNS, conduisant à un enregistrement DNS vide pour un endpoint régional, et des perturbations en chaîne.

Il faut traiter les dépendances comme des composants critiques : cartographie, tests, supervision, plans de contournement.

Ce que ces incidents disent vraiment : la panne n’est pas “matérielle”, elle est “logique”

Azure Front Door (config/control plane), Cloudflare (ops/automation), AWS DynamoDB (DNS automation) : contextes différents, conclusion proche.

Dans chaque cas, la rupture est liée à :

- Une configuration,

- Une automatisation,

- Une dépendance critique (DNS/edge/contrôle),

- Et/ou une faiblesse organisationnelle (tests, garde-fous, procédures).

La résilience cloud dépend moins des datacenters que de la maîtrise des couches logiques, humaines et opérationnelles.

Pourquoi certains “ne tombent pas” : la résilience comme discipline, pas comme promesse

Les organisations qui limitent l’impact d’un incident cloud ont rarement un “meilleur fournisseur”. Elles ont surtout :

- Des architectures pensées pour la dégradation contrôlée,

- Des mécanismes de bascule réellement testés,

- Une gouvernance IAM stricte (MFA, moindre privilège, secrets),

- Des runbooks et exercices réguliers (game days),

- Des objectifs mesurables (SLO, MTTR, réussite de restauration).

Le multi-région, par exemple, ne garantit rien s’il n’est pas conçu et testé. Une haute disponibilité théorique ne protège pas d’une erreur humaine ou d’une compromission d’identité.

Conclusion : la résilience est un processus continu.

Mesurer la résilience plutôt que la supposer

Une architecture peut afficher une forte disponibilité, tout en restant structurellement fragile. Les incidents récents montrent que les points de rupture se situent dans des couches souvent sous-estimées : DNS, identité, automatisations, dépendances externes, procédures de restauration. L’enjeu n’est donc plus seulement de “faire confiance au cloud”, mais de mesurer objectivement :

- Vos dépendances critiques,

- Vos scénarios de crise,

- Votre capacité de restauration,

- Votre maturité IAM,

- Votre répétabilité opérationnelle (tests, runbooks, supervision).

BYCYB, votre partenaire pour mesurer et améliorer la résilience de vos services cloud

BYCYB intervient auprès des organisations sur les volets techniques et organisationnels de la cybersécurité : évaluations, expertise, tests et formation des équipes. Entité créée par le LNE et CRYPT.ON IT, BYCYB a pour objectif d’aider les entreprises à mesurer, prioriser et renforcer durablement leur posture de sécurité.

Évaluez gratuitement votre niveau de sécurité cloud en quelques minutes.